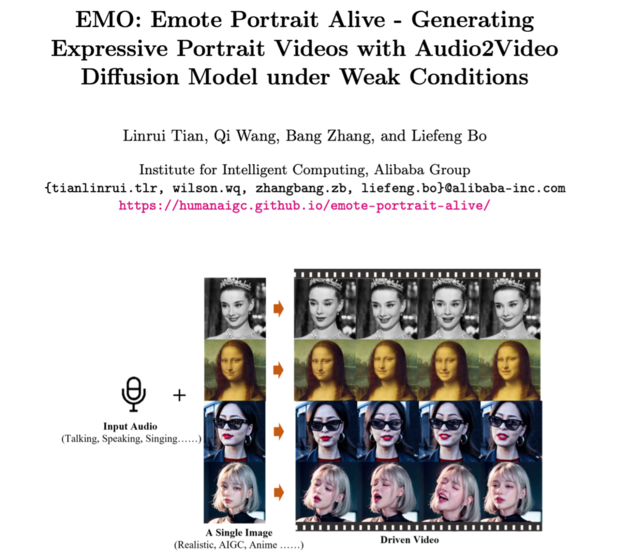

近日,阿里巴巴研究团队推出了一款名为“EMO(Emote Portrait Alive)”的AI框架。该框架能够实现对口型,用户只需输入人物照片和音频即可让照片中的人物开口说出相关音频,并且支持中英韩等多种语言。

EMO基于英伟达的Audio2Video扩散模型开发,经过超过250小时的专业视频训练而成。研究团队在ArXiv上分享了由EMO框架生成的DEMO演示片段,并提供了项目链接供有兴趣的人士查看。

据介绍,EMO框架的工作过程分为两个主要阶段。首先,研究人员利用参考网络从参考图像和动作帧中提取特征;然后,利用预训练的音频编码器处理声音并嵌入;同时结合多帧噪声和面部区域掩码来生成视频。为了确保视频中角色身份的一致性和动作的自然流畅,该框架还融合了两种注意机制和时间模块。

研究人员声称EMO不仅可以产生令人信服的说话视频,还能生成各种风格的歌唱视频,“显著优于目前的DreamTalk、Wav2Lip、SadTalker等竞品”。

本文属于原创文章,如若转载,请注明来源:阿里推出AI新框架能让照片开口说话连贯流畅!https://dcdv.zol.com.cn/858/8584765.html